Para Descargar PDF debe Abrir sesión.

Para Descargar PDF debe Abrir sesión.

Este texto completo es la transcripción editada y revisada de una conferencia dictada en reunión clínica del Departamento de Medicina, Hospital Clínico Universidad de Chile.

La publicación de estas actas ha sido posible gracias a una colaboración editorial entre Medwave y el Departamento de Medicina del Hospital Clínico Universidad de Chile. El director del Departamento de Medicina es el Dr. Alejandro Cotera.

Para planificar en forma adecuada la evaluación de la educación médica es fundamental establecer desde el principio y en forma clara los objetivos del aprendizaje, es decir, las competencias que el estudiante debe adquirir al final del proceso, ya que según esto se escogerá los instrumentos que se va a utilizar.

El autor clásico Kane señala que un profesional es competente en la medida en que utiliza los conocimientos, las habilidades, las actitudes y el buen juicio asociados a su profesión con la finalidad de desarrollarla en forma eficaz en aquellas situaciones que corresponden al campo de su práctica. La competencia, pues, pertenece al área del saber hacer (1). Esta definición implica dos hechos: que la competencia profesional es un problema de integración de distintos aspectos en la formación de alguien; y que dicha competencia se demuestra a través de la actuación en un terreno práctico.

Otra definición interesante es la de Ronald M Epstein, que describe a la competencia profesional como el uso cotidiano y juicioso del conocimiento, habilidades técnicas y de comunicación, juicio clínico, emociones, valores y reflexión en la práctica diaria para el beneficio de las personas y de la comunidad a la que se sirve (2). En esta definición se introduce una dimensión social y también de integración.

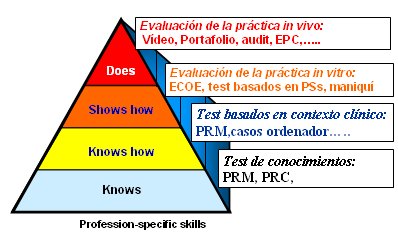

En la Fig.1 se muestra la pirámide de Miller, que establece cuatro niveles de aprendizaje con sus respectivos niveles de evaluación de competencias. En el nivel más básico, el conocer, se aplica la evaluación de los conocimientos, es decir, la capacidad para recordar cosas; en el segundo nivel, el cómo conocer, se evalúa la capacidad para entender cómo ocurren los fenómenos, es decir, para buscar información, analizarla e interpretar resultados; en el tercer nivel, el cómo mostrar, se evalúa la ejecución de lo que se ha aprendido, es decir, implica una acción, pero en una práctica in vitro, no en condiciones de práctica real; finalmente en el vértice de la pirámide está el hacer, que se evalúa es la práctica real, in vivo.

Figura 1. Pirámide de Miller: niveles de aprendizaje y evaluación.

Cada elemento de la pirámide de Miller se asocia a una serie de instrumentos de evaluación. En la base están las pruebas de conocimientos, en especial las preguntas de respuestas múltiples; en el segundo nivel se aplican pruebas en un contexto clínico, por tanto para responderlas se requiere razonar, no solamente recordar información; en el tercer nivel se evalúa mediante simulaciones; y en el vértice de la pirámide se puede aplicar múltiples instrumentos, como portafolios, videos, etc. Cabe señalar que los sistemas de evaluación modernos se introducen en España en la década de los 60, con los exámenes tipo test, mientras que las pruebas basadas en simulaciones para evaluaciones objetivas estructuradas, surgidas a medianos de los años 70 en el Reino Unido, sólo se empiezan a desarrollar en los años 90. La época actual se caracteriza por el surgimiento de un nuevo paradigma, proveniente de la literatura y experiencia anglosajonas, que se enfoca en la evaluación de la práctica real.

Existen dos niveles o tipos de evaluación: formativa y sumativa. La evaluación formativa pretende determinar el grado de avance de un estudiante en sus objetivos de aprendizaje, con el objetivo de subsanar los déficits que se detecten en ese momento; no tiene como objetivo calificar para aprobar o reprobar, por lo tanto, no es coercitiva. La evaluación sumativa, sancionadora o acreditativa tiene como objetivo determinar si el estudiante adquirió cierto cuerpo de conocimientos o competencias y por lo tanto va asociada a una nota o calificación que le entrega o no el derecho a pasar al siguiente ciclo. Lo que hace que una evaluación sea sumativa o formativa no es el tipo de instrumento que se utiliza, sino el propósito con que se utiliza; por ejemplo, el examen con base en preguntas de respuesta múltiple se asocia tradicionalmente a una evaluación sumativa, que mide conocimientos mediante una nota, pero también se puede utilizar en un objetivo formativo si se permite a los alumnos corregir el examen en clase para ver en qué falló.

Los instrumentos de evaluación deben cumplir con ciertas características:

Un ejemplo de instrumento de evaluación es el examen MIR, que se utiliza en España como requisito de ingreso a una especialidad médica y que consiste en un test de 250 preguntas de respuesta múltiple, en el que se evalúa fundamentalmente los dos primeros niveles de la pirámide de Miller, es decir, el conocimiento y el conocer cómo. En este contexto es importante recordar lo que Miller señalaba en el sentido de que “los sistemas de evaluación de alguna manera condicionan el sistema de aprendizaje”, por lo tanto ningún sistema de evaluación es inocuo o neutro.

Cuando se plantea una evaluación se debe tener claros los siguientes aspectos:

El 13 de febrero de 2008 el Estado español dictó un orden que fija los objetivos y competencias que los estudiantes deben adquirir al finalizar su formación de seis años en la Facultad de Medicina, agrupándolas en siete grandes bloques:

Esto permite determinar desde el principio el sistema de evaluación que se va a poner en marcha para ver si se consiguen estos objetivos y se adquieren estas competencias.

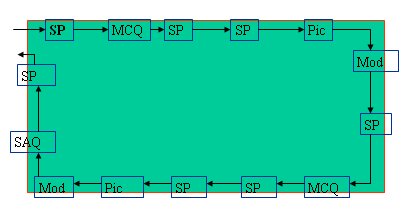

La ECOE es una utilización combinada, sistemática y estandarizada de distintos instrumentos de evaluación, principalmente encuentros clínicos, para evaluar las competencias previamente definidas a través de un circuito de estaciones. En la Fig. 2 se representa la ECOE como un circuito en el cual un alumno va pasando por una serie de estaciones en las que encuentra pacientes simulados, preguntas de respuesta múltiple, imágenes, maniquíes, etc., en función de objetivos que se han definido previamente (Fig. 2).

Figura 2. Esquema general de la evaluación clínica objetiva estructurada (ECOE)

Las competencias tradicionales que se evalúan en la ECOE son: anamnesis, exploración física, procedimientos, diagnóstico y diagnóstico diferencial, manejo del paciente y habilidades comunicativas. Además, en los últimos años se ha incorporado a otras competencias, como aspectos de ética, profesionalismo, valoración crítica, investigación, etc.

La ECOE tiene varias ventajas:

La ECOE tiene las siguientes desventajas:

Se ha determinado que para una evaluación formativa la ECOE debe tener entre ocho y quince estaciones y hasta tres horas de duración; mientras que para una evaluación sumativa se requiere como mínimo veinte estaciones, con una duración de cuatro a seis horas. En resumen, no es lo mismo aplicar la ECOE para una evaluación sumativa que para una evaluación formativa.

La ECOE se aplica en Cataluña para evaluar las competencias clínicas en licenciados, es decir, en estudiantes de sexto año de las cuatro facultades de Medicina, desde hace varios años, ya que los métodos tradicionales de evaluación no permiten evaluar en forma adecuada este aspecto. La experiencia obtenida en el período 1994-2006 está publicada (3).

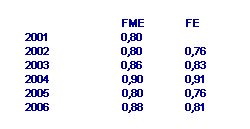

Entre 1994 y 1997 se trabajó con diez estaciones y entre 1998 y 2006, con veinte estaciones y catorce casos clínicos, para obtener un mínimo margen de seguridad. Además, a partir de 2001 se incorporó una fase escrita con 150 preguntas de selección múltiple, 20 de ellas asociadas a imágenes, lo que permite ampliar mucho más el ámbito de las competencias a evaluar. Entre 1994 y 2006 participaron 4.331 alumnos de sexto año y en 2006 se trabajó con 565 alumnos de las cuatro facultades. En ese lapso el coeficiente de fiabilidad alfa de Cronbach se mantuvo sobre 0,80, que es el mínimo recomendado, tanto en la fase de multiestación como en la fase escrita de la prueba (Tabla I).

Un estudiante de sexto año en España no tiene un internado como el de Chile, donde los estudiantes tienen relación con pacientes reales. En España el contacto con los pacientes es limitado y la responsabilidad frente a un paciente real también es limitada, por lo tanto es difícil valorar la práctica real. Por eso se ha elevado una propuesta al Ministerio español para que considere a la ECOE como un elemento más dentro del examen MIR de ingreso a las especialidades, que actualmente solamente evalúa conocimientos.

Las comisiones nacionales designadas para ello establecen la definición de competencias y elaboran el Programa Nacional de Especialidades, que se convierte en Ley cuando el Ministerio lo aprueba. En el último tiempo se ha ido definiendo en forma cada vez más precisa las competencias que debe alcanzar el futuro especialista o médico en su proceso de especialización, así como el proceso de evaluación formativa y sumativa que debe superar. En febrero de 2008 se emitió un Decreto que modifica sustancialmente los sistemas de evaluación y formación especializada en España y hace especial hincapié en la evaluación formativa, sin dejar de considerar la evaluación sumativa; sin embargo el tema es complejo y sensible y su aplicación no está exenta de controversia.

En el curso de la formación especializada hay tres elementos fundamentales a evaluar:

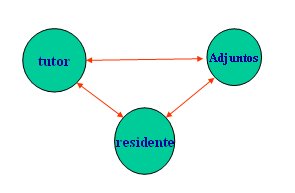

En España ha surgido con especial fuerza en los últimos años la figura del tutor, que es el profesional encargado de seguir todo el proceso de formación del residente. El tutor debe: determinar los objetivos específicos del aprendizaje; evaluar en qué medida se van cumpliendo mediante los recursos de preguntar, observar y mirar, mediante distintos métodos; y finalmente debe establecer la triangulación, que es un elemento clave, porque el residente rota por distintos servicios, donde queda a cargo de un adjunto. La triangulación, que es la comunicación entre tutor, residente y adjunto en función de objetivos previamente establecidos, es fundamental para que el seguimiento de ese residente sea adecuado (Fig. 3).

Figura 3. Triangulación tutor-residente-adjunto.

Un elemento importante de la evaluación sumativa es el feedback o retorno de información. Jack Ende, que ha escrito artículos especialmente claros y brillantes sobre el tema, señala que “sin feedback los errores no se corrigen, los aspectos positivos no se refuerzan y la competencia clínica se consigue de forma empírica o no se llega a conseguir” (4).

En España la evaluación sumativa depende del Ministerio, que la aplica través de Comisiones Nacionales en centros sanitarios acreditados para la formación. Los hospitales, los tutores y los adjuntos siguen siendo ejecutores, pero no tienen competencias en el diseño del modelo evaluativo. Aquí es fundamental tener claro las competencias que se van a evaluar; a quién se va a evaluar; con qué nivel; y cómo será la evaluación final, que no es lo mismo que un examen final. En la evaluación final se deberá aplicar una serie de métodos con un peso ponderado predeterminado; por ejemplo: preguntas de respuesta múltiple 20%, evaluación continuada 20%, observación estructurada 30%, auditorías de historia 15% y portafolio, 15%; porcentajes todos ellos con un significado meramente ilustrativo.

Actualmente se está impulsando en Cataluña la aplicación de la Observación estructurada de la práctica clínica (OEPC), también conocida como mini-CEX, en su versión original inglesa. Se trata de un instrumento para evaluar habilidades clínicas que tiene las siguientes características: trabaja con casos clínicos reales, es decir, en el vértice de la pirámide; hay un observador cada vez; se presentan distintos casos en distintos entornos; se utiliza una ficha estructurada para recoger la información; entrega retroalimentación al evaluado y se lleva a cabo en un tiempo factible, alrededor de quince minutos. El mini-Cex fue creado en los Estados Unidos por el American Board of Internal Medicine a partir del antiguo CEX (Clinical Evaluation Examination), el examen tradicional, que consumía mucho tiempo, una a dos horas y se hacía con un solo paciente y un solo observador, lo que afectaba la validez y fiabilidad y ocasionaba mucho estrés al examinado.

El mini-CEX evalúa una serie de competencias, al igual que la ECOE y entrega los mismos resultados con menor costo y esfuerzo organizativo. Entre las competencias valoradas están: habilidades de entrevista clínica, habilidades de exploración física, cualidades humanas y profesionalismo, juicio clínico, counseling skills y organización y eficiencia; esto sin perder de vista un objetivo muy importante, que es elaborar descriptores del perfil satisfactorio que sirvan de base para la evaluación global final del evaluador. Un ejemplo de perfil satisfactorio es: “demuestra satisfactoriamente juicio clínico, capacidad de síntesis y de resolución y tiene en cuenta aspectos de eficiencia, valorando riesgos y beneficios en el plan de manejo”.

El mini-CEX recoge los siguientes datos descriptivos: evaluador, residente, año de residencia, fecha, entorno clínico (urgencia, consulta externa), datos del paciente, motivo principal de la consulta, complejidad del caso, categoría del observador (adjunto, tutor), perfil de patologías. Entre los aspectos prácticos se recomienda al observador presentarse al paciente si es necesario; cuidar su posición de modo que tener buen ángulo de visión sin interferir sobre el accionar del evaluado; tener conocimiento del nivel esperado y exigible al observado; estar familiarizado con la ficha y los aspectos valorados (descriptores de las competencias) y mantener la concentración y atención. Los estudios demuestran que el mini-CEX proporciona una medida válida y fiable sobre la base de seis encuentros clínicos al año valorados por distintos observadores.

La observación estructurada tiene varias ventajas:

Entre las limitaciones de la observación estructurada se cuentan las siguientes:

En Cataluña se estableció que los encargados de aplicar el mini-CEX son los tutores, de modo que éstos deben asistir a un taller de cuatro horas de duración para explicarles cómo se utiliza este instrumento. En una encuesta que se envió por correo electrónico a 120 tutores que habían asistido al taller, se les preguntó si estaban aplicando el mini-CEX: 50% de ellos contestaron la encuesta y de éstos, alrededor de 50% lo estaban utilizando. Esto demuestra que la formación es un elemento necesario, pero no suficiente para lograr que el uso de este instrumento se masifique, de modo que se debe diseñar estrategias para superar los posibles obstáculos, como la falta de voluntad y de recursos. Se está planificando la formación de pequeños grupos para hacer un seguimiento de las personas que han recibido formación para aplicar el mini-CEX.

La práctica profesional es el tercer eslabón del proceso educativo, después del pregrado y de la formación especializada. Dicha práctica se puede evaluar, como describió Norcini en 2003, con base en:

Entre los instrumentos disponibles para valorar la práctica profesional, en pleno vértice de la pirámide de Miller, están: los registros clínicos; los diarios de aprendizaje, logbooks o portafolios; la observación de la práctica en forma directa o a través de grabación de video y datos administrativos relevantes. En el caso de la observación, el video tiene la ventaja de que permite al evaluado verse a sí mismo en acción, lo que es muy útil para corregir errores. Los instrumentos descritos tienen distinto grado de validez, fiabilidad y factibilidad (Tabla II).

Tabla II. Propiedades de algunos instrumentos de evaluación de la práctica profesional.

Se denomina portafolio a la recogida, más o menos sistemática, de elementos que evidencian el aprendizaje o nivel de competencia conseguido según objetivos establecidos con anterioridad, y que va acompañado de un proceso de reflexión. Actualmente en España se está debatiendo en forma muy activa sobre el portafolio y ya se está implementando algunas experiencias concretas con este instrumento; de hecho la Sociedad Española de Medicina Interna está llevando a cabo un proyecto piloto de ejecución de un portafolio de objetivos y alcance moderados que permitirá acotar su campo de acción al observar las dificultades que se encuentren para llevarlo a cabo. En Medicina Familiar y Comunitaria también existe un portafolio oficial del Ministerio, que es mucho más ambicioso, pero aún no se ha puesto en marcha.

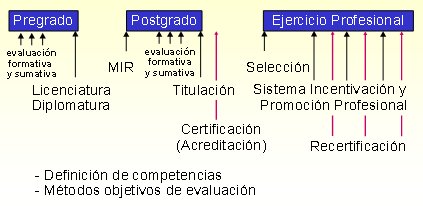

Cees van der Vleuten, Director del Departamento de Educación Médica de la Universidad de Maastricht, Holanda, una de las pioneras en temas de educación médica en Europa junto a la de Dundee, en Escocia, plantea que en la formación médica lo principal no es aplicar un instrumento de evaluación más o menos objetivo, sino elaborar un programa que defina los niveles de evaluación a través de todo el desarrollo individual profesional, que es un proceso continuo, de modo que los instrumento que se apliquen en cada nivel se definan con base no sólo en su validez y fiabilidad, sino también considerando su impacto educativo, aceptabilidad, recursos que consuma y finalidad de la evaluación (5). Es distinto evaluar para entregar el derecho a ejercer como especialista, a realizar una evaluación formativa (Fig. 4).

Figura 4. Desarrollo profesional continuo individual: niveles de evaluación.

La implementación de un portafolio contempla las siguientes etapas:

En el desarrollo de un portafolio hay tres aspectos clave: el diseño del instrumento, la estrategia de aplicación y la evaluación de esta aplicación.

En resumen, existen distintos tipos de portafolio, en distintos ámbitos y con distintos propósitos, pero en todos los casos se trata de un contenedor de evidencias de aprendizaje y competencias que facilita la reflexión sobre el propio proceso de aprendizaje. El diseño, aplicación y evaluación del portafolio son diferentes según se utilice en el ámbito de la formación pregraduada, especializada o en el desarrollo profesional continuo, y los sujetos de la acción pueden ser estudiantes, docentes, residentes o profesionales en ejercicio. Igualmente condicionante es el propósito con que se plantee el portafolio en cada uno de los ámbitos, sumativo o formativo. El portafolio, además de permitir valorar los resultados del aprendizaje, promueve el desarrollo de estrategias, actividades, habilidades y procesos cognitivos esenciales para el aprendizaje a lo largo de toda la vida profesional.

Cuando se plantea un portafolio de ejecución obligada es importante evitar que ocurran efectos perversos, como que se pierda autenticidad, frescura y espontaneidad y se induzca a la persona a hacer más bien lo “políticamente correcto” en función de lo que se exige, lo que llevará a evaluar la calidad de dicho portafolio. Por todo ello, no se debe usar el portafolio para medir aspectos de la competencia que se pueden medir mejor con otros instrumentos; no obstante, sí se puede incluir estos resultados en el portafolio. No hay ningún instrumento que pueda evaluar por sí solo la competencia profesional en su conjunto; para esto se requiere un sistema integrado de evaluación que combine diferentes métodos.

Figura 1. Pirámide de Miller: niveles de aprendizaje y evaluación.

Figura 1. Pirámide de Miller: niveles de aprendizaje y evaluación.

Figura 2. Esquema general de la evaluación clínica objetiva estructurada (ECOE)

Figura 2. Esquema general de la evaluación clínica objetiva estructurada (ECOE)

Tabla I. Coeficiente de fiabilidad alfa de Cronbach para la ECOE. FME= fase de multiestación, FE= fase escrita.

Tabla I. Coeficiente de fiabilidad alfa de Cronbach para la ECOE. FME= fase de multiestación, FE= fase escrita.

Figura 3. Triangulación tutor-residente-adjunto.

Figura 3. Triangulación tutor-residente-adjunto.

Tabla II. Propiedades de algunos instrumentos de evaluación de la práctica profesional.

Tabla II. Propiedades de algunos instrumentos de evaluación de la práctica profesional.

Figura 4. Desarrollo profesional continuo individual: niveles de evaluación.

Figura 4. Desarrollo profesional continuo individual: niveles de evaluación.

Esta obra de Medwave está bajo una licencia Creative Commons Atribución-NoComercial 3.0 Unported. Esta licencia permite el uso, distribución y reproducción del artículo en cualquier medio, siempre y cuando se otorgue el crédito correspondiente al autor del artículo y al medio en que se publica, en este caso, Medwave.

Esta obra de Medwave está bajo una licencia Creative Commons Atribución-NoComercial 3.0 Unported. Esta licencia permite el uso, distribución y reproducción del artículo en cualquier medio, siempre y cuando se otorgue el crédito correspondiente al autor del artículo y al medio en que se publica, en este caso, Medwave.

Este texto completo es la transcripción editada y revisada de una conferencia dictada en reunión clínica del Departamento de Medicina, Hospital Clínico Universidad de Chile.

La publicación de estas actas ha sido posible gracias a una colaboración editorial entre Medwave y el Departamento de Medicina del Hospital Clínico Universidad de Chile. El director del Departamento de Medicina es el Dr. Alejandro Cotera.

Expositor:

José María Fornells Vallés[1]

Expositor:

José María Fornells Vallés[1]

Citación: Fornells JM. Assessment in medical education. Medwave 2009 Ene;09(1):3702 doi: 10.5867/medwave.2009.01.3702

Fecha de publicación: 1/1/2009

Nos complace que usted tenga interés en comentar uno de nuestros artículos. Su comentario será publicado inmediatamente. No obstante, Medwave se reserva el derecho a eliminarlo posteriormente si la dirección editorial considera que su comentario es: ofensivo en algún sentido, irrelevante, trivial, contiene errores de lenguaje, contiene arengas políticas, obedece a fines comerciales, contiene datos de alguna persona en particular, o sugiere cambios en el manejo de pacientes que no hayan sido publicados previamente en alguna revista con revisión por pares.

Nombre/name: Ricardo Molina

Fecha/date: 2011-03-15 19:18:19

Comentario/comment:

Es un articulo muy util para los que nos dedicamos a este tipo de actividad docente. Creo que la mayoria de los médicos que trabajamos con estudiantes de pregrado o pregrado utilizamos de forma sistematica todos estos elementos de evaluación, sin embargo lo dificil es tener la evidencia de lo que hacemos, por eso es muy importante contar con los instrumentos de evaluación. Ojala alguno de ustedes pudiera enviarme algun instrumento de evaluación sobre todo en lo que se refiere al posgrado.

Muchas gracias.

Para comentar debe iniciar sesión

Medwave publica las vistas HTML y descargas PDF por artículo, junto con otras métricas de redes sociales.

Medwave publica las vistas HTML y descargas PDF por artículo, junto con otras métricas de redes sociales.

Kane MT. The assessment of professional competence. Eval Health Prof. 1992 Jun;15(2):163-82. | CrossRef | PubMed |

Kane MT. The assessment of professional competence. Eval Health Prof. 1992 Jun;15(2):163-82. | CrossRef | PubMed | Epstein RM, Hundert EM. Defining and assessing professional competence. JAMA. 2002 Jan 9;287(2):226-35. | CrossRef | PubMed |

Epstein RM, Hundert EM. Defining and assessing professional competence. JAMA. 2002 Jan 9;287(2):226-35. | CrossRef | PubMed | Kronfly Rubiano E, Ricarte Díez JI, Juncosa Font S, Martínez Carretero JM. Evaluación de la competencia clínica de las facultades de medicina de cataluña, 1994-2006: evolución de los formatos de examen hasta la evaluación clínica objetiva estructurada (ECOE). Med Clin (Barc). 2007 Dec 1;129(20):777-84. | CrossRef | PubMed |

Kronfly Rubiano E, Ricarte Díez JI, Juncosa Font S, Martínez Carretero JM. Evaluación de la competencia clínica de las facultades de medicina de cataluña, 1994-2006: evolución de los formatos de examen hasta la evaluación clínica objetiva estructurada (ECOE). Med Clin (Barc). 2007 Dec 1;129(20):777-84. | CrossRef | PubMed |